Ronaldo Lemos: “A inteligência artificial precisa ser moderada”

Advogado fundador do Instituto de Tecnologia e Sociedade (ITS Rio) rebate fala do presidente do OpenAI sobre o fim da moderação de conteúdo diante da ascenção da inteligência artificial

No primeiro dia do SXSW de 2023, o co-presidente da OpenAI, criadora do ChatGPT, respondeu à repórter que o entrevisava que uma das primeiras profissões que iria desaparecer com o avanço da inteligência artificial seria moderador de conteúdo, tarefa que, segundo ele, “você não quer o julgamento humano e só uma lista de regras que um computador pode avaliar”. A visão de Ronaldo Lemos difere da anterior.

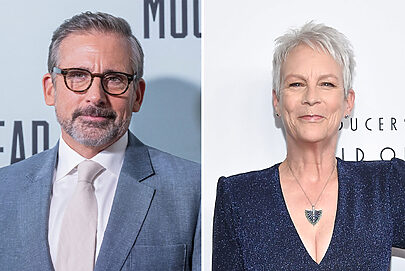

Ronaldo Lemos é especialista em tecnologia, propriedade intelectual, mídia e políticas públicas (Crédito: Thaís Monteiro)

Advogado co-criador do Marco Civil da Internet e do Plano Nacional de Internet das Coisas no Brasil, diretor do Instituto de Tecnologia e Sociedade do Rio de Janeiro, membro do Comitê de Supervisão da Meta, Ronaldo Lemos esteve no South by Southwest como painelista em um debate sobre o futuro da moderação de conteúdo. O advogado também esteve no festival para apresentar o Marco Civil da Internet.

OpenAI e ChatGPT: pró-humano e pró-ética

Na sua opinião, a inteligência artificial — tópico de grande debate na edição deste ano –, vai ajudar na moderação de conteúdo, mas também irá trazer desafios aos moderadores, que deverão treinar e corrigir as rotas dos bots.

Ex-presidente do Creative Commons, ao Meio & Mensagem Lemos também compartilhou suas percepções sobre os desafios da Web 3 e da descentralização para regulamentação e moderação.

Meio & Mensagem – Você mencionou em seu painel que IA pode ser um remédio e um veneno para a moderação de conteúdo ao mesmo tempo. Por que?

Ronaldo Lemos – A chegada desses modelos grandes de linguagem, como o ChatGPT, vai ter um impacto grande sobre a questão da moderação. Primeiro, cada vez mais inteligência artificial vai ser utilizada como forma de moderação, de processar, analisar sentimento, analisar conteúdo para ver se não há violação de regras graves. Ao mesmo tempo, vai haver uma demanda cada vez maior por moderação de conteúdo. Não é que a inteligência artificial vai substituir a moderação. Pelo contrário, a inteligência artificial também precisa ser moderada, ser treinada e de forma permanente. Vimos o que aconteceu com o Bing, da Microsoft, nas últimas semanas. Ele apresentou alguns comportamentos erráticos. Isso demonstra que a inteligência artificial demanda muito trabalho humano para que haja um processo de moderação sobre a forma como ela funciona. Em outras palavras, inteligência artificial erra e erra muito. A moderação também vai ser diferente, porque você trabalhar com IA é diferente de trabalhar com conteúdo em plataforma.

O presidente do OpenAI esteve no SXSW e opinou que uma das primeiras profissões a desaparecer por conta da inteligência artificial seria moderador de conteúdo. Ele descreve que são profissões que você não quer o julgamento humano e só uma lista de regras que um computador pode avaliar. Qual é sua opinião sobre essa afirmação? Além disso, pode o IA substituir o olhar humano nesse sentido?

Ele está totalmente errado, porque a inteligência artificial em si demanda uma moderação de conteúdo gigantesca. Inclusive, alguém deveria ter perguntado pra ele, por exemplo, o fato de que muitas inteligências artificiais estão sendo treinadas em países em desenvolvimento, inclusive pobres, como é o caso do Quênia, onde são contratados inúmeros moderadores desse modelo que passam o dia executando tarefas de controle desses modelos, muitas delas repetitivas e maçantes, para impedir que esses modelos fiquem repetindo os seus erros. Hoje vemos países como Bangladesh, Índia, tendo muita gente contratada para treinar modelos de inteligência artificial. A inteligência artificial pode contribuir nos processos de moderação de conteúdo, mas ela erra e muitas vezes ela é a origem de discursos perigosos como a gente viu inclusive nas semanas anteriores. A demanda por essa questão tende a aumentar.

Como será a tecnologia nos próximos dez anos

Há várias tecnologias de código aberto emergindo, sejam metaveros ou outras opções da web 3.0. Quais são as perspectivas relacionadas a regulamentação desses espaços? É viável? Há esforços na moderação desses ambientes?

O que estamos vivendo hoje é, mais uma vez, a dualidade entre centralização e concentração, como é o caso do surgimento das big techs, e também uma tendência de descentralização puxando por outro lado. Já estão surgindo modelos de inteligência artificial hoje que são open source, descentralizados. Você tem também a chamada Web 3 que também propaga a ideia de descentralizar os serviços da web que a gente conhece hoje. Essa dualidade entre centralização e descentralização está se repetindo novamente. Ela já aconteceu antes nos anos 2000 com a descentralização representada pela Wikipédia e pela ideia de jornalismo cidadão, pelo Reddit e depois perdeu o fôlego para o movimento de centralização que levou ao surgimento de plataformas centralizadas e assim por diante. Estamos começando a reviver essa dualidade, essa dicotomia e inclusive no território da inteligência artificial. Cada modelo tem seus problemas, desafios e vantagens. Por exemplo, inteligências artificiais descentralizadas e a própria Web 3 são muito mais difíceis de serem reguladas e moderadas. Ao mesmo tempo existe a possibilidade dessas tecnologias também promoverem formas de comunidade descentralizadas que se autoregulam.

Elon Musk, que assumiu o Twitter recentemente, questiona muito a moderação de conteúdo e até fez afirmações que já foram banidas da rede anteriormente. Outras redes sociais estão chegando com a premissa de proteger a liberdade de expressão a todo custo. Quão grande e quais são as consequências dessa ameaça? O que podemos esperar do futuro das plataformas levando isso em consideração?

Com relação ao modelo do Twitter, que com a chegada do Elon Musk tem diminuído os esforços de moderação, o problema é que a plataforma pode ser capturada facilmente por maliciosos. Isso, inclusive, já aconteceu na época do Ísis, também conhecido como Estado Islâmico que utilizou eh plataformas incluindo o Twitter pra promover radicalização de pessoas, ameaça a populações locais com invasão e conflito armado. Esse tipo de descontinuidade de um esforço de moderação pode levar a um processo de perigo para determinadas populações. O grande problema é o surgimento do que a gente chama de discursos perigosos, aquele que é capaz de gerar violência, de gerar violência física, violência contra minorias, conflitos armados e assim por diante. O problema da moderação de conteúdo não é um problema político, ideológico. Há casos e existem inúmeras evidências com relação a isso de que processos intensos de radicalização levaram a violência gigantesca. É o caso que aconteceu em Ruanda onde por anos foram veiculados discursos perigosos e esses discursos levaram a um massacre literalmente, que afetou centenas de milhares de pessoas. Você abrir mão totalmente de moderar conteúdo não é uma situação de total liberdade. A liberdade de expressão é sempre a regra, sempre tem que ser importante deixar isso muito claro, mas a total ausência de moderação também leva a possibilidade de violência.